Khi “cơn ác mộng” deepfake hoành hành

22/10/2023 | Tác giả: KHÔI NGUYÊN Lượt xem: 561

Trong bối cảnh các tiến bộ công nghệ liên tục định hình mạng xã hội và phương tiện truyền thông đại chúng, “deepfake” đang là mối quan ngại lớn khi số lượng những vụ lừa đảo ngày càng gia tăng…

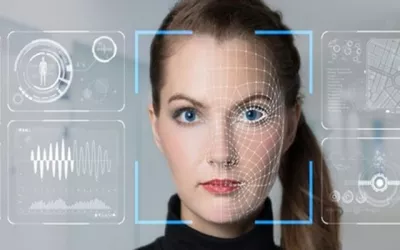

Theo đó, thời gian gần đây xuất hiện một thủ đoạn lừa đảo mới hết sức tinh vi khiến không ít người “sập bẫy”. Đó là việc các đối tượng lừa đảo lợi dụng công nghệ Deepfake (công nghệ ứng dụng trí tuệ nhân tạo) để tạo ra các đoạn video với hình ảnh, khuôn mặt nhân vật giống hệt như hình ảnh của người dùng muốn giả mạo để yêu cầu “nạn nhân” chuyển tiền. Thủ đoạn lừa đảo này từng được các chuyên gia dự báo sẽ “nở rộ”, là mối nguy hại trong thời gian tới.

Anh Lê Duy Tùng (Gia Lâm, Hà Nội ) cho biết, cách đây vài ngày, anh Tùng đang làm việc thì nhận được tin nhắn của bạn thân qua Facebook với nội dung “Cho tôi mượn tạm 20 triệu đồng, đang có việc cần gấp”; đồng thời người này nhờ chuyển số tiền đó vào tài khoản của người khác. Nghi ngờ Facebook của bạn bị hack nên anh Tùng đã gọi video để kiểm chứng. Phía bên kia bắt máy, anh Tùng thấy mặt bạn nhưng hơi mờ nên có thắc mắc thì được bạn trả lời đang ở vùng sóng yếu.

Vì thấy được bạn qua video call nên anh Tùng yên tâm chuyển khoản 20 triệu đồng theo số tài khoản người bạn yêu cầu. Sau đó, anh Tùng gọi điện thoại trực tiếp cho bạn thì mới biết mình đã sập bẫy công nghệ “deepfake”.

Cũng là nạn nhân khi “dính” bẫy lừa tương tự, chị Nguyễn Thị Hồng Nhung (Sóc Sơn, Hà Nội) đang làm việc thì nhận được tin nhắn của bạn thân qua Facebook với nội dung “Cho mình mượn tạm 10 triệu đồng mình cần gấp” và yêu cầu chuyển thẳng số tiền đó vào tài khoản của người thứ 3 để “đỡ mất công phải chuyển đi chuyển lại. Lúc nào chuyển xong thì chỉ cần chụp hình ảnh gửi cho mình”.

Nghi ngờ Facebook người bạn bị chiếm tài khoản nên chị Nhung đã gọi video để kiểm chứng. Phía bên kia bắt máy, mở video cho chị Nhung thấy mặt nhưng hình ảnh hơi mờ. Khi chị Nhung hỏi sao hình ảnh mờ thì bên kia trả lời "đang vùng sóng yếu". Thấy hình ảnh bạn, chị Nhung đã tin tưởng và chuyển 10 triệu đồng vào tài khoản. Sau khi chuyển tiền, chị Nhung gọi điện thoại cho bạn thì mới biết mình bị lừa.

Trao đổi xung quanh câu chuyện này, các chuyên gia công nghệ cho biết, trong tình huống trên đối tượng đã sử dụng công nghệ Deepfake AI, tạo ra các sản phẩm công nghệ âm thanh, hình ảnh, video làm giả người ngoài đời thực với độ chính xác tương đối cao. Để thực hiện được hình thức lừa đảo này, các đối tượng tìm kiếm, thu thập thông tin cá nhân, hình ảnh, video có giọng nói được đăng tải công khai trên các tài khoản mạng xã hội… rồi sử dụng công nghệ Deepfake để tạo sẵn những video rất khó phân biệt thật - giả, có hình ảnh, giọng nói của cá nhân đó để phục vụ cho kịch bản lừa đảo.

Đặc điểm chung của những cuộc gọi video như vậy thường có âm thanh, hình ảnh không rõ nét, tín hiệu chập chờn giống như cuộc gọi video trong khu vực phủ sóng di động hoặc wifi yếu để nạn nhân khó phân biệt thật, giả. Để tránh bị “sập bẫy”, các chuyên gia khuyến cáo và đề nghị người dùng cần nâng cao cảnh giác khi nhận bất kỳ tin nhắn, cuộc gọi video với nội dung vay, mượn tiền qua các ứng dụng mạng xã hội. Sau đó phải thực hiện ngay thao tác kiểm tra bằng cách gọi điện thoại trực tiếp cho người thân để xác minh (không gọi qua các ứng dụng như Zalo, Messenger, Viber).

Thông tin thêm về thủ đoạn này, chuyên gia bảo mật Vũ Ngọc Sơn, Giám đốc Kỹ thuật Công ty Công nghệ An ninh mạng Việt Nam (NCS) cho biết: Deepfake ban đầu được sử dụng trong các ứng dụng “hoán đổi khuôn mặt” giúp người sử dụng dễ dàng thay khuôn mặt, giọng nói của mình vào những nhân vật trong các bộ phim nổi tiếng, rồi đến trào lưu chế ảnh, lồng tiếng hài hước cho các clip từng gây sốt thời gian trước. Tuy nhiên, gần đây, những kẻ lừa đảo đã lợi dụng ứng dụng Deepfake để làm ra các clip có nội dung lừa đảo, mạo danh. Nhiều người đã bị mất tiền do tưởng là người thân, đồng nghiệp, lãnh đạo gọi cho mình yêu cầu chuyển một khoản tiền cho họ.

Cũng theo ông Sơn, do năng lực tính toán của các ứng dụng Deepfake chưa hoàn hảo, nên các clip “chế” từ công nghệ này thường có dung lượng nhỏ, thời gian ngắn, chất lượng âm thanh, hình ảnh không cao. Vì thế, người dùng không nên tin các clip có thời lượng ngắn, chất lượng clip thấp, nhòe, không rõ, khuôn mặt ít biểu cảm, cơ thể ít di chuyển và giọng nói không trơn tru, không ngắt nghỉ…

Đáng chú ý, cũng liên quan đến vấn đề này, bà Võ Dương Tú Diễm - Giám đốc khu vực Việt Nam của Kaspersky nhận định có nhiều tội phạm sử dụng deepfake để lừa đảo, đến mức nhu cầu sử dụng vượt xa nguồn cung các phần mềm deepfake hiện có trên thị trường.

Theo bà Diễm, khi cầu vượt cung, các vụ lừa đảo bằng deepfake sẽ tăng cao với nhiều hình thức đa dạng và tinh vi hơn. Từ cung cấp một video mạo danh chất lượng cao với đầy đủ dịch vụ sản xuất cho đến việc sử dụng hình ảnh người nổi tiếng trong luồng phát trực tuyến giả mạo (fake livestream) trên mạng xã hội và hứa hẹn sẽ thanh toán gấp đôi số tiền nạn nhân đã gửi họ.

"Deepfake đã trở thành cơn ác mộng đối với phụ nữ và xã hội. Tội phạm mạng hiện khai thác trí tuệ nhân tạo để ghép khuôn mặt nạn nhân vào ảnh và video khiêu dâm cũng như trong chiến dịch tuyên truyền. Những hình thức này nhằm mục đích thao túng dư luận bằng cách phát tán thông tin sai lệch hoặc thậm chí gây tổn hại đến danh tiếng của tổ chức hoặc cá nhân. Chúng tôi kêu gọi công chúng nâng cao cảnh giác trước mối đe dọa này", bà Võ Dương Tú Diễm nói.

Theo Tạp chí Diễn đàn Doanh nghiệp

https://diendandoanhnghiep.vn/khi-con-ac-mong-deepfake-hoanh-hanh-252815.html